تشهد محركات البحث المدعومة بالذكاء الاصطناعي، التي قدمت في البداية نتائج متفوقة على أدوات البحث التقليدية، تراجعاً ملحوظاً في الأداء. يشكو المستخدمون من أن منصات البحث الذكية مثل Perplexity باتت تقدم معلومات غير دقيقة من مصادر مشكوك في موثوقيتها، خاصة فيما يتعلق بالبيانات المالية والإحصائيات التجارية. فبدلاً من الاعتماد على مصادر موثقة مثل ملفات هيئة الأوراق المالية والبورصات الأمريكية (SEC)، تلجأ هذه الأنظمة بشكل متزايد إلى مواقع غير موثوقة تحتوي على معلومات مضللة.

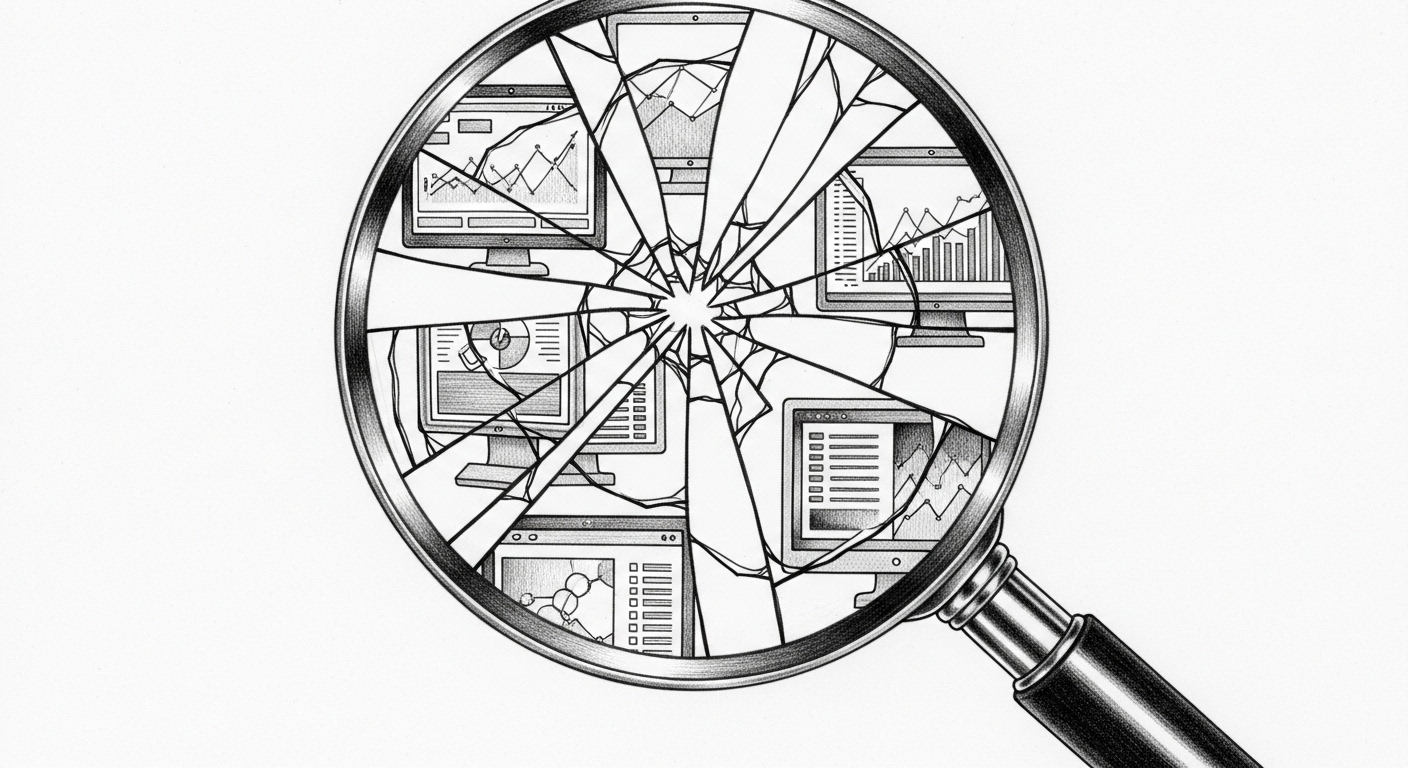

يُعزى هذا التدهور إلى ظاهرة 'انهيار نموذج الذكاء الاصطناعي' - وهي حالة تفقد فيها أنظمة الذكاء الاصطناعي المُدربة على مخرجاتها الخاصة دقتها وموثوقيتها بشكل تدريجي. تتفاقم هذه المشكلة جراء الكم الهائل من المحتوى المُولد بالذكاء الاصطناعي الذي يغمر شبكة الإنترنت. تنتج OpenAI وحدها نحو 100 مليار كلمة يومياً، والكثير من هذا المحتوى ينتهي به المطاف على الإنترنت ليُعاد استخدامه في تدريب نماذج ذكية جديدة. ينشأ عن ذلك دورة مفرغة تتراكم فيها الأخطاء، مما يجعل أنظمة الذكاء الاصطناعي 'تتسمم بإسقاطاتها الخاصة للواقع'، حسب وصف الباحثين المختصين.

النقاط الرئيسية

- محركات البحث بالذكاء الاصطناعي تواجه تراجعاً في الجودة، خاصة عند التعامل مع الاستعلامات التي تتطلب مصادر بيانات موثوقة

- انهيار النموذج يحدث عندما تُدرب أنظمة الذكاء الاصطناعي على مخرجاتها الخاصة، مما يؤدي إلى تراكم الأخطاء عبر الأجيال المتتالية

- انتشار المحتوى المُولد بالذكاء الاصطناعي على الإنترنت يُسرع من تدهور جودة بيانات التدريب

- حتى التقنيات المتطورة مثل التوليد المُعزز بالاستخلاص (RAG) يمكن أن تزيد من مخاطر تسريب البيانات والنتائج المنحازة

- الاستخدام المكثف للذكاء الاصطناعي في توليد محتوى مزيف - من الأوراق الأكاديمية إلى مراجعات الكتب الوهمية - يُلوث البيئة المعلوماتية

في جملة واحدة

تبدأ محركات البحث بالذكاء الاصطناعي في إظهار علامات تراجع في الجودة نتيجة انهيار النموذج، حيث تفقد الأنظمة المُدربة على مخرجاتها الخاصة دقتها تدريجياً. إن تدفق المحتوى المُولد بالذكاء الاصطناعي على الإنترنت يخلق دورة تغذية راجعة قد تجعل هذه الأدوات أقل موثوقية مع مرور الوقت.

المصادر: 1