في جملة واحدة

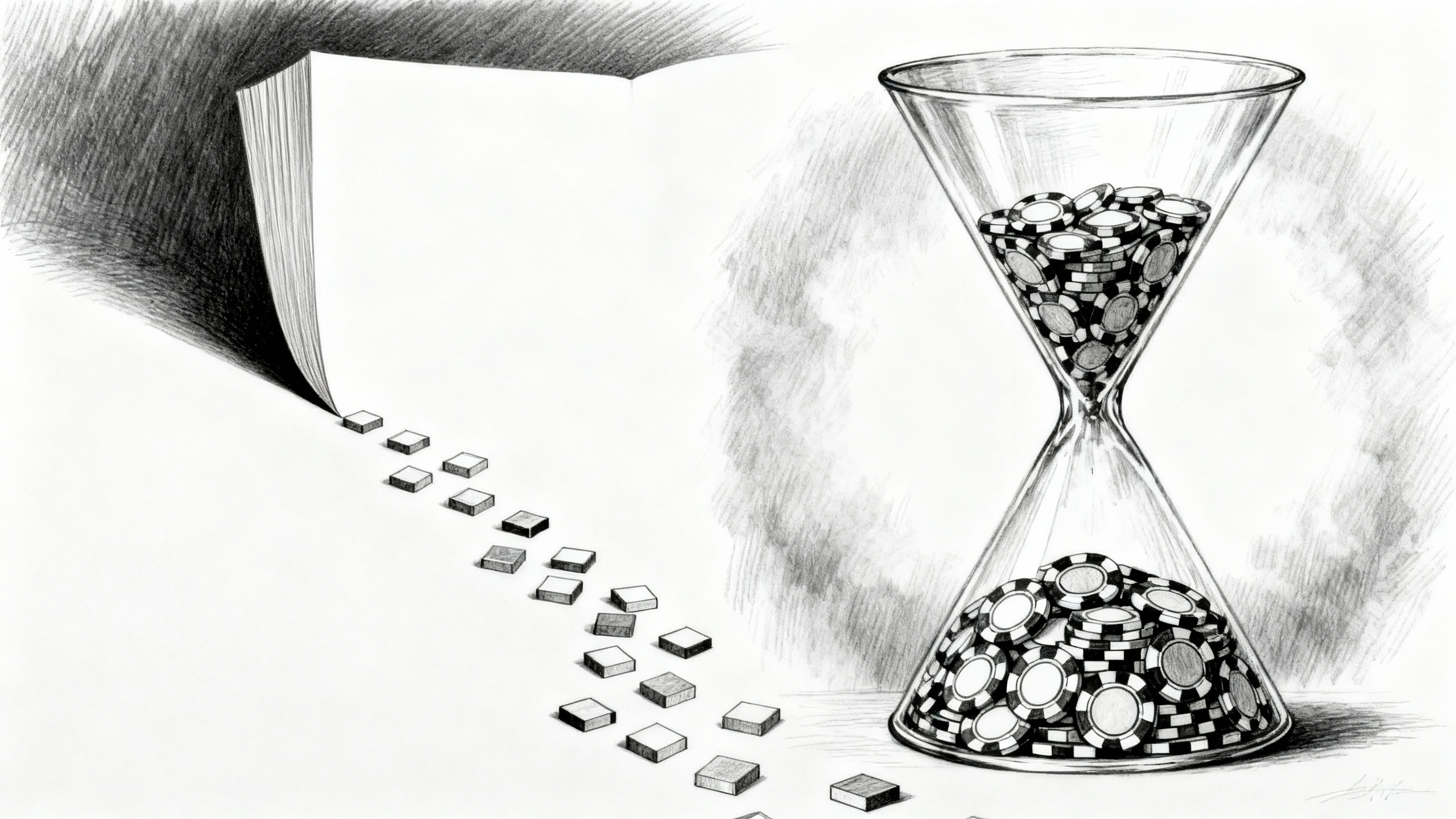

يكشف نموذج التعرف البصري على الحروف (OCR) مفتوح المصدر من DeepSeek أن تمثيل النص كصور يمكن أن يضغط السياق حتى 10x مع الحفاظ على دقة عالية. قد يفتح هذا النهج الباب أمام نوافذ سياق أوسع بكثير ويبسّط عملية التجزئة (tokenization)، لكن أثره على الاستدلال فوق رموز بصرية مضغوطة لا يزال غير محسوم.

التفاصيل

أتاحت DeepSeek نموذج DeepSeek-OCR كمصدر مفتوح، وهو نموذج يقلب فرضية أساسية في الذكاء الاصطناعي عبر ضغط النص على هيئة صور. بتحويل النص إلى رموز بصرية (vision tokens)، يحقق النظام ضغطاً يصل إلى نحو 10x مع دقة فك الترميز (decoding accuracy) تقارب 97% عندما تكون الرموز البصرية أقل من عُشر رموز النص (tokens). على معيار Fox، أعاد 100 رمز بصري فقط بناء صفحات تضم 700–800 رمزاً نصياً بدقة 97.3%. ويرى باحثون ومهنيون في القطاع أن ذلك قد يمهّد الطريق لنوافذ سياق (context windows) أوسع بكثير — ربما ضمن نطاق 10–20 مليون رمز — وقد يقلّل أيضاً من الاعتماد على المجزئات النصية التقليدية والهشّة (tokenizers).

وعملياً، يحقق النموذج معدل إنتاجية مرتفعاً: إذ تستطيع وحدة معالجة رسوميات واحدة من نوع Nvidia A100-40G (GPU) معالجة أكثر من 200,000 صفحة يومياً، مع قابلية للتوسّع إلى نحو 33 مليون صفحة يومياً عبر عنقود يضم 20 عقدة (cluster). ويتفوّق DeepSeek-OCR على أبرز خطوط الأساس (baselines) في OmniDocBench مستخدماً عدداً أقل بكثير من الرموز (tokens)، كما يدعم أوضاع دقة متعددة لتلبية حالات استخدام مختلفة. تضم بنيته (architecture) مُرمِّزاً بصرياً بعدد 380 مليون معلمة، يتبعه مُفكِّك ترميز من نوع مزيج الخبراء (MoE decoder) بعدد 3 مليارات معلمة (570 مليون فعّالة)، وقد جرى تدريبه على 30 مليون صفحة PDF تغطي نحو 100 لغة، إلى جانب بيانات اصطناعية (synthetic data) ثرية. ومع ذلك، يبقى سؤال مفتوح رئيسي: هل تستطيع نماذج اللغة الكبيرة (LLMs) الاستدلال بالكفاءة نفسها على سياقات واسعة تُمثَّل أساساً كرموز بصرية مضغوطة؟

النقاط الرئيسية

- يضغط DeepSeek-OCR النص عبر رموز بصرية (vision tokens)، محققاً تقليصاً بنحو 7–10x مع دقة فك ترميز تقارب ~97%؛ وعلى معيار Fox، أعاد 100 رمز بصري بناء 700–800 رمزاً نصياً.

- معدل الإنتاجية مرتفع: نحو 200 ألف صفحة/يوم على وحدة A100-40G واحدة (GPU)، مع التوسّع إلى ~33 مليون صفحة/يوم على عنقود 20×8 GPU (cluster).

- يتفوّق على GOT-OCR2.0 وMinerU2.0 في OmniDocBench باستخدام عدد أقل بكثير من الرموز (tokens)، ويقدّم أوضاع دقة متعددة (من Tiny إلى "Gundam").

- البنية (architecture): مُرمِّز DeepEncoder بعدد 380 مليون معلمة + مُفكِّك ترميز من نوع مزيج الخبراء (MoE) بعدد 3 مليارات معلمة (570 مليون فعّالة)، مُدرَّب على 30 مليون صفحة PDF عبر نحو 100 لغة، إضافةً إلى بيانات اصطناعية تشمل مخططات ومعادلات ورسومات.

- تشمل التداعيات المحتملة نوافذ سياق (context windows) بحجم 10–20 مليون رمز وتقليص الاعتماد على المجزئات (tokenizers) ومشكلاتها، لكن لا يزال غير واضح مدى قدرة نماذج اللغة الكبيرة (LLMs) على الاستدلال فوق سياقات بصرية مضغوطة.