في جملة واحدة

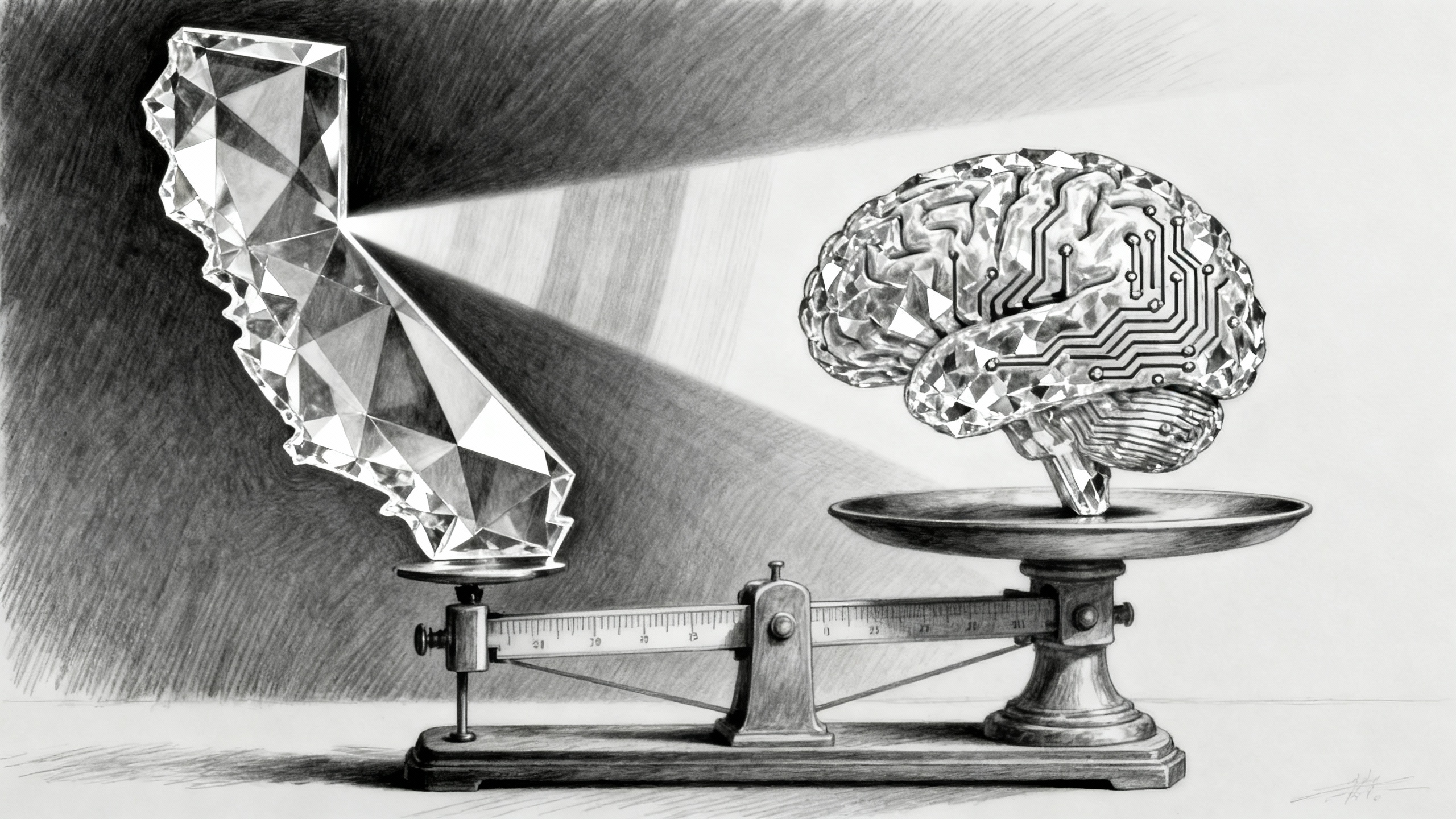

أصبح SB 53 قانونًا في كاليفورنيا، مُلزمًا مطوّري الذكاء الاصطناعي (AI) الكبار بالشفافية والإبلاغ، مع توفير حماية للمبلّغين عن المخالفات. يوازن الإجراء بين الإشراف على السلامة ودعم الابتكار، لكنه لا يفرض تدقيقات من طرف ثالث (third-party audits).

التفاصيل

وقّع حاكم كاليفورنيا، غافين نيوسوم، قانون الشفافية في الذكاء الاصطناعي المتقدّم (Frontier AI) (SB 53)، ليصبح نافذًا بعد أن رُفض العام الماضي مشروع قانون أكثر صرامة (SB 1047). يُلزم القانون الجديد مطوّري أنظمة الذكاء الاصطناعي الكبار بالإفصاح علنًا عن كيفية امتثالهم للمعايير الوطنية والدولية وأفضل ممارسات الصناعة ضمن إجراءات السلامة والأمن لديهم. كما يتعيّن على الشركات نشر أي تحديثات لهذه البروتوكولات — وبيان مبرّراتها — خلال 30 يومًا.

ينشئ SB 53 قناة للإبلاغ عن الحوادث الحرجة المحتملة المتعلقة بسلامة الذكاء الاصطناعي إلى مكتب خدمات الطوارئ في كاليفورنيا، ويحمي المبلّغين عن المخالفات عند كشفهم عن مخاطر كبيرة على الصحة والسلامة ناجمة عن النماذج المتقدّمة (frontier models). كما يقرّ بعقوبات مدنية على عدم الامتثال تُنفّذ من قِبل المدّعي العام، ويكلّف إدارة تكنولوجيا كاليفورنيا بتقديم توصيات تحديث سنوية. ورغم تبنّيه عدة توصيات خبراء، لا ينصّ القانون على تقييمات مستقلة من طرف ثالث (third-party evaluations). وقد تباينت مواقف الصناعة: أيّدت Anthropic المشروع، بينما سعت Meta وOpenAI إلى بدائل متوافقة مع الأطر الفدرالية أو العالمية.

النقاط الرئيسية

- يُلزم القانون مطوّري الذكاء الاصطناعي (AI) الكبار بنشر أطر وإجراءات السلامة والأمن وشرح أي تحديثات خلال 30 يومًا.

- ينشئ مسارًا للإبلاغ عن الحوادث لدى مكتب خدمات الطوارئ في كاليفورنيا.

- تُحمى حقوق المبلّغين عن المخالفات عند إفصاحهم عن مخاطر كبيرة على الصحة والسلامة ناجمة عن النماذج المتقدّمة (frontier models).

- يؤدي عدم الامتثال إلى عقوبات مدنية تُنفّذ من قِبل المدّعي العام.

- لا تتضمن اللائحة تقييمات من طرف ثالث؛ وتتباين ردود فعل القطاع، إذ تؤيد Anthropic بينما يدعو آخرون إلى مواءمة فدرالية أو عالمية.

المصادر: 1