في جملة واحدة

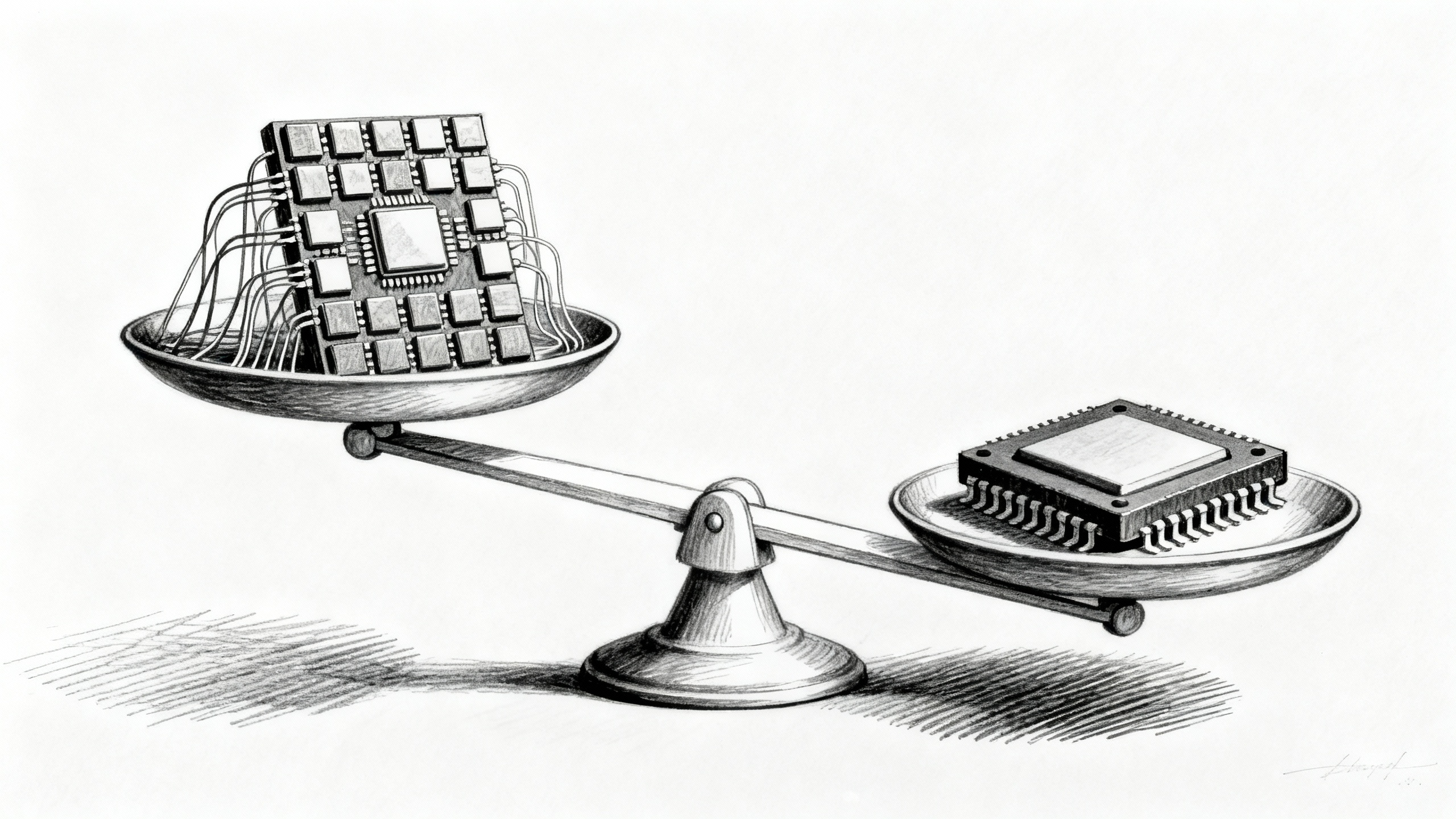

يوفّر TPUv7 من Google مساراً أقل تكلفة وقابلاً للتوسّع بدرجة عالية للتدريب والاستدلال، متحدّياً قبضة Nvidia على البنية التحتية للذكاء الاصطناعي. وبينما تخفّض وحدات معالجة التنسورات (TPU) التكاليف وتقلّص ميزة CUDA، تظل وحدات معالجة الرسوميات (GPU) أساسية بفضل مرونتها—ما يوحي بمستقبل هجين.

التفاصيل

شكّلت وحدات معالجة الرسوميات (GPU) من Nvidia المحرّك لمعظم الطفرات الحديثة في الذكاء الاصطناعي، لكن عتاد Google الأحدث TPUv7 يغيّر المشهد. فقد جرى تدريب النماذج الحدودية (frontier models) مثل Gemini 3 من Google وClaude 4.5 Opus من Anthropic على TPUv7، وهي رقائق مصمَّمة خصيصاً ومُحسَّنة لحسابات المصفوفات الرياضية على نطاق واسع، مع وصلات بينية عالية السرعة تمكّن عناقيد TPU (TPU pods) من العمل كحاسوب فائق واحد. النتيجة: زمن استجابة أقل، وقابلية توسّع أفضل، واقتصاديات أفضل لأعباء التدريب والاستدلال (inference) الضخمة.

تغيّر Google أيضاً أسلوب تسويق هذه التقنية. فإلى جانب الاستئجار عبر السحابة، باتت تطرح وحدات معالجة التنسورات (TPU) مباشرةً للعملاء—وقد تجلّى ذلك في صفقة مفصلية مع Anthropic للحصول على ما يصل إلى 1,000,000 رقاقة TPUv7 (نحو 400,000 مُورَّدة عبر Broadcom و600,000 مُستأجرة عبر Google Cloud). يقدّر المحلّلون أن TPUv7 يحقق وفورات كبيرة في إجمالي تكلفة الملكية (TCO)—بنحو 44% داخلياً مقارنةً بأنظمة Nvidia المماثلة، ونحو 30% للمشترين الخارجيين—وهو ما يضغط على تسعير وحدات GPU في السوق ككل. ولتقليص الميزة التنافسية طويلة الأمد لـCUDA، قدّمت Google دعماً أصيلاً لـPyTorch وتعمل على تحسين أطر الاستدلال الشائعة مثل vLLM وSGLang. ومع ذلك، تظل وحدات معالجة الرسوميات (GPU) أكثر مرونة وأسهل من حيث توافر الكفاءات، ما يرجّح انتشار المكدّسات الهجينة TPU–GPU في الأمد القريب.

النقاط الرئيسية

- جرى تدريب Gemini 3 وClaude 4.5 Opus على TPUv7 من Google، ما يعزّز اعتبارها بديلاً موثوقاً لوحدات معالجة الرسوميات (GPU) من Nvidia على مستوى النماذج الحدودية (frontier models).

- تبيع Google الآن وحدات معالجة التنسورات (TPU) عبر السحابة وبشكل مباشر؛ صفقة Anthropic تشمل ما يصل إلى 1,000,000 رقاقة (400 ألف مُورَّدة، و600 ألف مُستأجرة).

- يقدّر المحلّلون أن TPUv7 يمكنه خفض إجمالي تكلفة الملكية (TCO) بما بين 30% و50% على نطاق واسع، مع نحو 44% توفيراً داخلياً مقارنةً بأنظمة Nvidia المماثلة.

- الدعم الأصيل لـPyTorch، إلى جانب تحسينات vLLM وSGLang، يقلّل الاحتكاك أمام الفرق التي تنتقل من مسارات عمل تتمحور حول CUDA.

- تتفوق وحدات معالجة التنسورات (TPU) في أعباء عمل التنسورات الكبيرة، لكن وحدات معالجة الرسوميات (GPU) ما تزال تتفوّق في المرونة وتوافر الكفاءات وسرعة الطرح في السوق—ما يدفع الكثيرين نحو مكدّسات هجينة.

المصادر: 1